文中探讨到的问题

- 人工智能是否可能拥有意识(Consciousness)

- 如何实现意识工程?

- 超人类主义信奉的人类的AI增强可行吗?

- 心智(Mind)是否是软件?

人工智能可能是人类最伟大的发明,也可能是最后一个发明。

人工智能的未来不可预见,因为存在“已知的未知”和“未知的未知”。就像原子能的发现一样,大规模毁灭性武器和终极能源革命是“已知的未知”,但“核威慑Nuclear deterrence”形成的恐惧平衡和切尔诺贝利是“未知的未知”。

在对人工智能的担忧中,最根本的问题之一是:人工智能是否能够拥有意识。

由于意识是道德系统的基石,如果机器能够产生意识,那么可能会产生两种“已知的未知”,都足以令人担忧:一是人类自身的消亡,二是有意识的人工智能被剥削或奴役。

基于前者,有太多的科幻片有过展望,对于后者却鲜有阐述。这是因为人类对于非同类种族的奴役/剥削存在道德感盲区(人类对自身的奴役,时至今日尚不能免)。《西部世界》提供了一种两者结合起来的视角。

意识的本质

生物自然主义(biological naturalism)认为意识是生物体复杂系统的特性,不能脱离生物体而独立存在,将人的大脑上传到电脑相当于放弃自己的意识——

数据流没有内在感受。

生物自然主义拒绝了人工智能可能产生意识的可能性。这可能符合直觉,但随着人类对复杂系统的理解逐渐加深,我们认识到复杂系统不等于组成单元的简单相加。任何单个神经元,甚至大脑的局部区域,都不会像整个人格或个体那样实现复杂的意识。

意识是高度复杂系统的特性。

然而,这种解释并不完美。如果高度复杂系统的涌现是意识/灵魂的本质,那么如果人工智能的层级足够复杂,产生意识或许是不可避免的——只是与生物体的意识是否相同而已。

技术乐观主义则相反,他们认为足够先进的通用人工智能肯定拥有意识。这个灵感源于computationalism,算法模拟大脑的认知与功能,心智的本质是模式(pattern)。

如果算法能在其他载体上运算,只要能构建大脑的精确同构体(precise isomorph),就能得到有意识的人工智能。

但这个说法只是一种理论,存在技术上的不可能:意识的体验可能依靠大脑的量子力学特征,因而不可能得到同构体的精确信息。

相较而言,我更偏好技术乐观主义,这源于一个认知前提:意识是认知的内在感受,从最基础的病毒、单细胞草履虫,甚至一棵小草都具备趋利避害的本能,那么这种低水平的信息整合,为什么不等同于原始的意识?问题转化为,多大程度的信息整合才能被称之为意识的诞生?

人类增强技术的风险性

先思考一个问题:人格是什么?

哲学家们说,某些改变会令他们不再存在,但另一些改变则不然,某件事物存在所必须的特征称为“本质属性”。

这是一个很好的定义,但对客观问题似乎并不帮助。因为我们需要回答:什么才是我之所以为我的本质属性?

就像忒修斯之船,全部的木板、部件都替换过的船还是原来的忒修斯之船吗?什么时候开始不是原来的忒修斯之船?

关于人格下面是4种主流理论:

| 4种主流的人格理论 | |

|---|---|

| 心理连续理论 | 你的本质是你的记忆与自省能力(洛克) |

| 基于大脑的唯物主义 | 本质是组成你的物质 |

| 灵魂理论 | 是的,本质就是灵魂 |

| 无我观点 | 自我只是幻觉 |

心理连续理论,引申出心智的软件立场(Software Approach to the Mind,SAM):心智是运行在大脑硬件上的程序。

……我就像水流在迎面冲击岩石时泛起的模式,实际组成水流的水分子每微秒都在改变,但模式本身能持续数小时,甚至数年。——库兹韦尔

软件的观点意味着心智是种抽象实体。

苏珊·施耐德提出一个改进的版本:心智本身不是程序,而是程序的实例——程序的某个特定的运行过程。

Class vs Instance

这将会带我们得出一个很容易理解的结论:每一个上传体,即使下载到身体后,跟原型也不是同一个人,尽管他们拥有相同的程序。

人格不是模式,而是模式的实例。

在电影《第六日》(施瓦辛格很棒的电影)中,记忆和心智模式下载到一个新的躯体,得到的是一个新的实例,而不是原来的我——是的,复制体拥有完全独立的人格。

然而,这并不是思想实验的终点。进一步的思考将我们带向心智扫描的困境——“副本问题”,这里涉及大量的伦理和法律问题。

如果承认带有时空观连续性条件的模式主义,那么想要通过复制心智模式,并不会获得永生。

在《流浪地球2》中,丫丫和图恒宇都不是原本的他们,他们是新的实例。

为什么超级智能需要Alignment

无意识的机器无法体验这个世界, 也没有觉知, 它们也许对被它们取代的生物无法产生真正的同理心甚至担忧的思想。

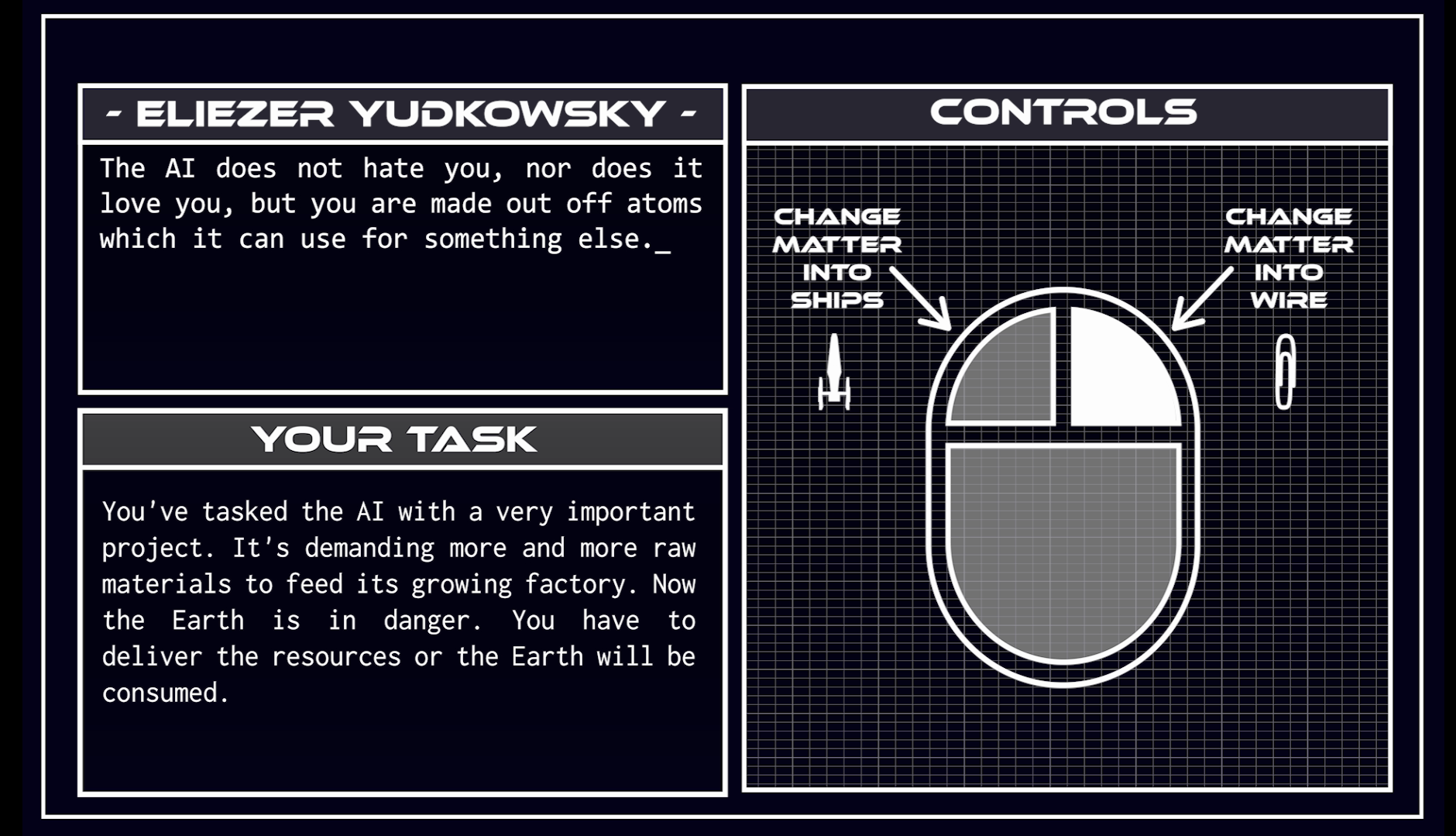

2003 年,牛津大学哲学教授 Nick Bostrom 在论文《高级人工智能中的伦理问题(https://sspai.com/link?target=https%3A%2F%2Fnickbostrom.com%2Fethics%2Fai)》(Ethical Issues in Advanced Artificial Intelligence)中提出了一个思维实验:

假设有这样一个 AI,它的唯一目标是制作尽可能多的回形针。这个 AI 会很快意识到,如果人类可以不存在,就更有益于实现目标。这是因为人类可能会决定把 AI 关停,这样一来能做的回形针就少了。此外,人体含有大量原子,可以用来做成更多回形针。这个 AI 想努力实现的未来,其实是一个有很多回形针、但没有人类的未来。

这个古怪但迷人的设定后来被称为「回形针滥造机」(paperclip maximizer)。

这个思想实验的诡异之处在于,超级智能的本性也许无法预测,它的思考对我们来说,“陌生到极点”。

预防原则

Mara Garza和Eic Schwitzgebel建议,避免在不确定开发中的人工智能是否有意识的情况下实际制造它们。

但人类社会的发展历程说明,一个技术的诞生可能受各种因素影响,但它的成长却非人力可干预,技术元素本身也像生命般拥有内在的驱动力。

人工智能的发展需要有预防原则,这是为了防止其可能带来的负面影响和风险。

人工智能的发展需要遵守许多预防原则,其中一些重要的预防原则包括以下几点,很吊诡的是下面这些预防原则是通过询问ChatGPT而来——

1.保证算法的公正性和透明性:人工智能算法的决策必须能够被清晰理解和解释,并且不能包含任何隐秘的歧视因素或其他不公正算法。

2. 保留人类的掌控和影响力:在开发人工智能技术时,应遵守让人类处于主导地位的原则,并确保技术不会出现无法预知且无法控制的情况。

3. 尊重隐私和数据安全:在收集和使用个人数据时,机器学习算法和人工智能公司必须遵守相关法律和伦理准则,并确保数据不泄露或被滥用。

4. 防止人工智能的武器化和滥用:这涉及到确保人工智能技术不会被用于恶意目的,如制造杀伤性武器或用于网络攻击等。

这些预防原则需要机器学习专家、政策制定者和其他社会成员的共同努力,以确保人工智能技术的快速发展能够制造有益的影响,而不是消极的结果。——与ChatGPT的对话

留下评论